Les médias d’information continent de jouer un rôle dans l’élaboration du récit autour des élections européennes ainsi que dans l’émergence d’une opinion publique européenne. Quelles stratégies pour couvrir la campagne, selon Amélie Reichmuth dans « How pan-European news organisations are approaching EU election coverage » pour VoxEurop et The European Correspondent, sans oublier de commencer par Politico Europe ?

L’approche analytique Politico Europe : une couverture « data-driven » des élections européennes

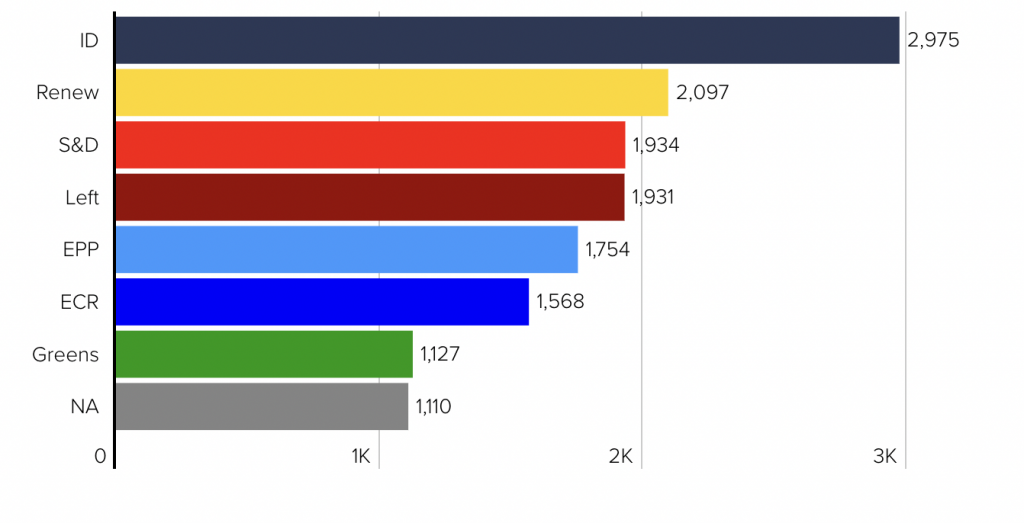

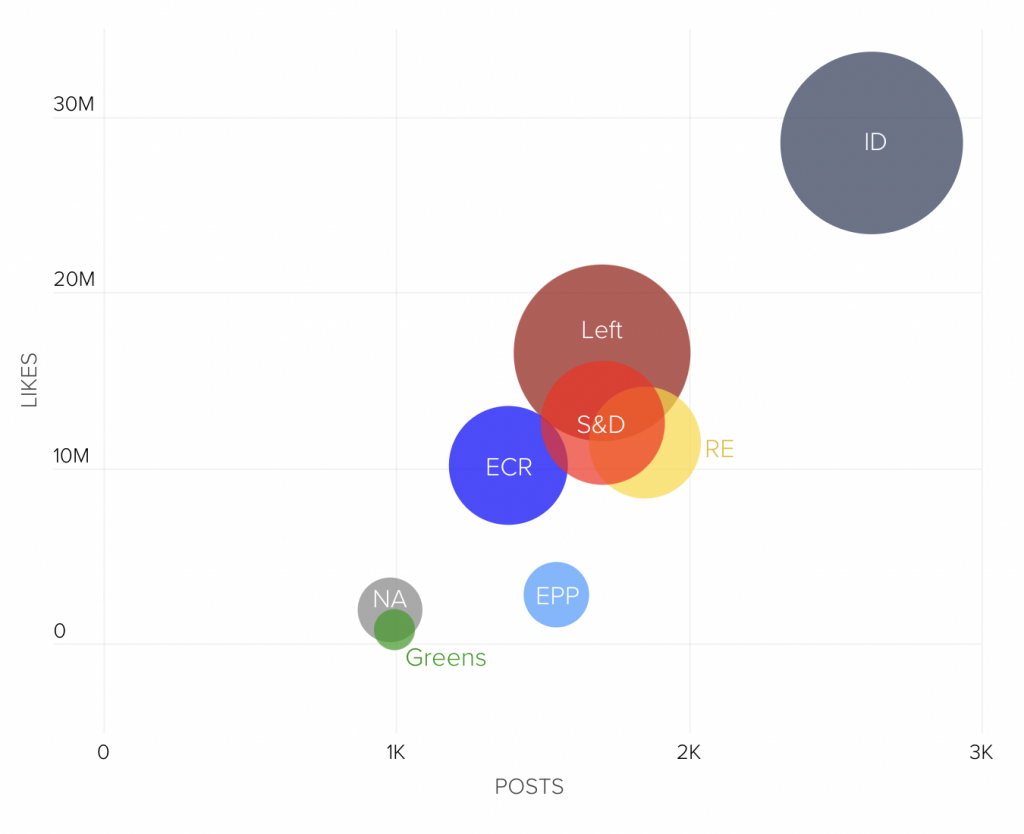

Politico Europe, lancée en 2015, basé à Bruxelles, offre une couverture approfondie de la politique, des politiques et des personnalités de l’UE. Pour les élections européennes, outre le narratif de la course électorale dans ses newsletters, podcasts et articles, Politico Europe adopte notamment une approche analytique « By the numbers » basée sur les données pour couvrir la campagne : enquête sur l’usage de Tiktok des députés européens ou les dépenses publicitaires des partis politiques.

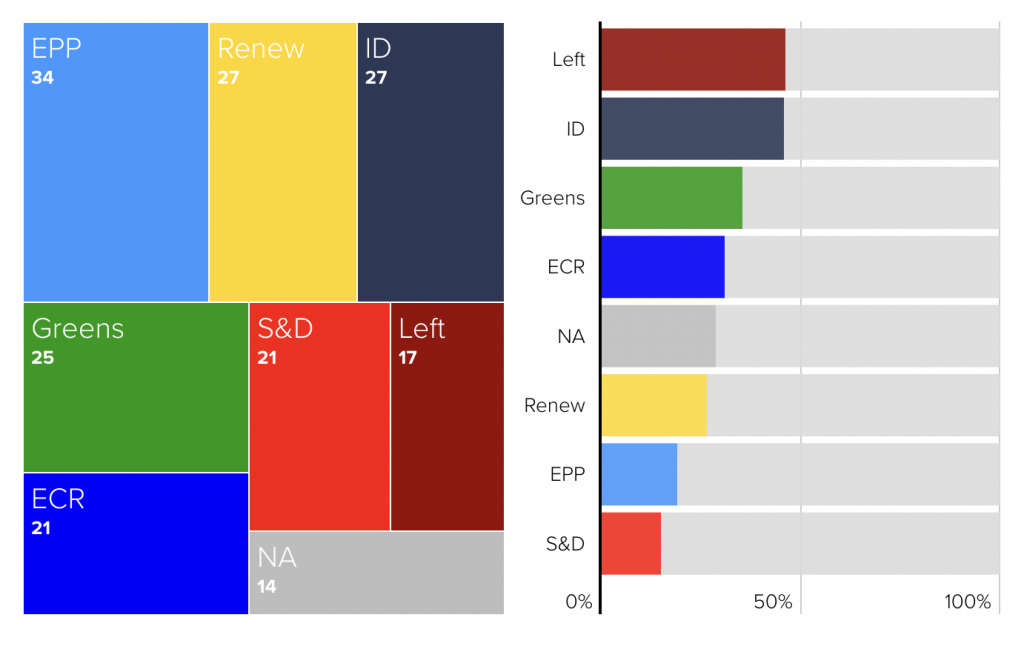

De plus, Politico Europe développe un outil interactif, « Poll of Polls », qui regroupe les dernières données de sondages de toute l’UE et fournit des estimations de la répartition des sièges au Parlement européen. Cet outil, mis à jour quotidiennement, vise à aider les citoyens et les parties prenantes à mieux comprendre la dynamique de la course électorale et les implications potentielles des résultats.

L’approche communautaire de The European Correspondent : un traitement « crowd-sourcé » des questions du public autour des sujets européens

Lancée en 2022, The European Correspondent est une newsletter qui se concentre sur les grands défis sociétaux, les changements politiques et les idées à travers le continent. Forte d’un réseau de plus de 140 correspondants locaux, la plateforme a pour objectif de proposer à ses lecteurs les meilleures histoires de chaque pays.

Pour The European Correspondent, les élections européennes constituent une opportunité essentielle de dialoguer avec son public. Julius Fintelmann, co-fondateur et directeur de la rédaction, estime que les élections sont importantes non seulement par leur résultat, mais aussi parce qu’elles génèrent un élan européen, avec des citoyens manifestant davantage d’intérêt pour les affaires européennes.

Leur stratégie pour couvrir les élections consiste à se concentrer sur les grandes questions qui intéressent les citoyens européens, plutôt que de suivre la campagne électorale à Bruxelles. Ils utilisent des explications et des articles approfondis pour aborder des sujets tels que le processus électoral, la montée des partis d’extrême droite et le Green Deal.

L’approche semble trouver un écho auprès de son public, qui reçoit de nombreuses questions sur les élections qui ne sont pas abordées ailleurs. Ils capitalisent sur cela à travers des campagnes d’engagement communautaire, visant à développer leur communauté et à élargir leur audience globale.

L’approche coopérative de Voxeurop : un traitement en mode « série » éditoriale

Voxeurop, lancé en 2014, se positionne comme le premier média géré par une société coopérative européenne afin de couvrir des sujets transnationaux, traduits dans les principales langues européennes, pour refléter la diversité des regards et toucher un public plus large.

L’année 2024 marque les 10 ans de Voxeurop, ce qui en fait une opportunité idéale pour élargir son lectorat. Voxeurop adopte plusieurs séries éditoriales pour couvrir les élections. L’un de leurs projets les plus réussis est « Voices of Europe« , où ils collaborent avec 27 grands médias nationaux pour publier des articles sur les principales questions en jeu dans les élections européennes de chaque pays. Ces articles sont ensuite traduits et publiés en cinq langues sur la plateforme Voxeurop.

Au total, les médias paneuropéens adoptent des stratégies diverses et innovantes pour couvrir les élections européennes, interagir avec leur public et contribuer au développement d’une sphère publique européenne, jouant un rôle crucial pour répondre aux préoccupations et aux questions de leur public et utiliser les élections comme une opportunité pour élaborer des nouvelles formes de récit autour d’un avenir de l’UE plus informé et plus engagé.