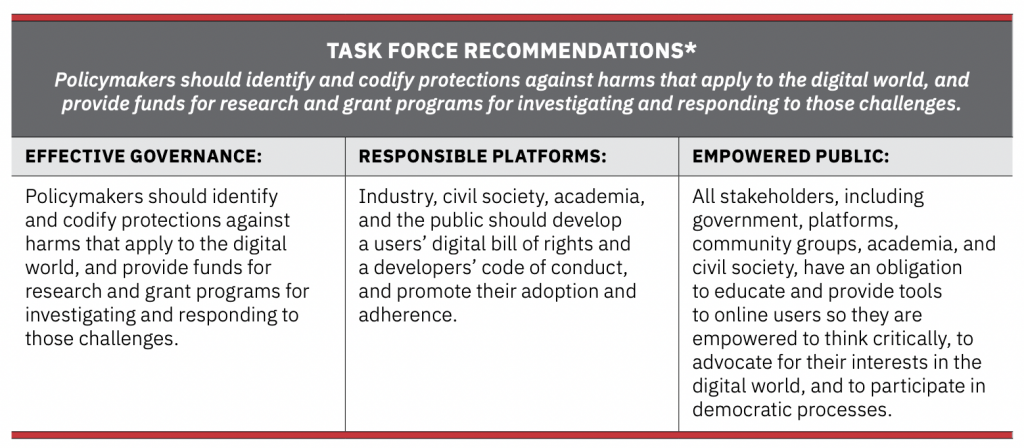

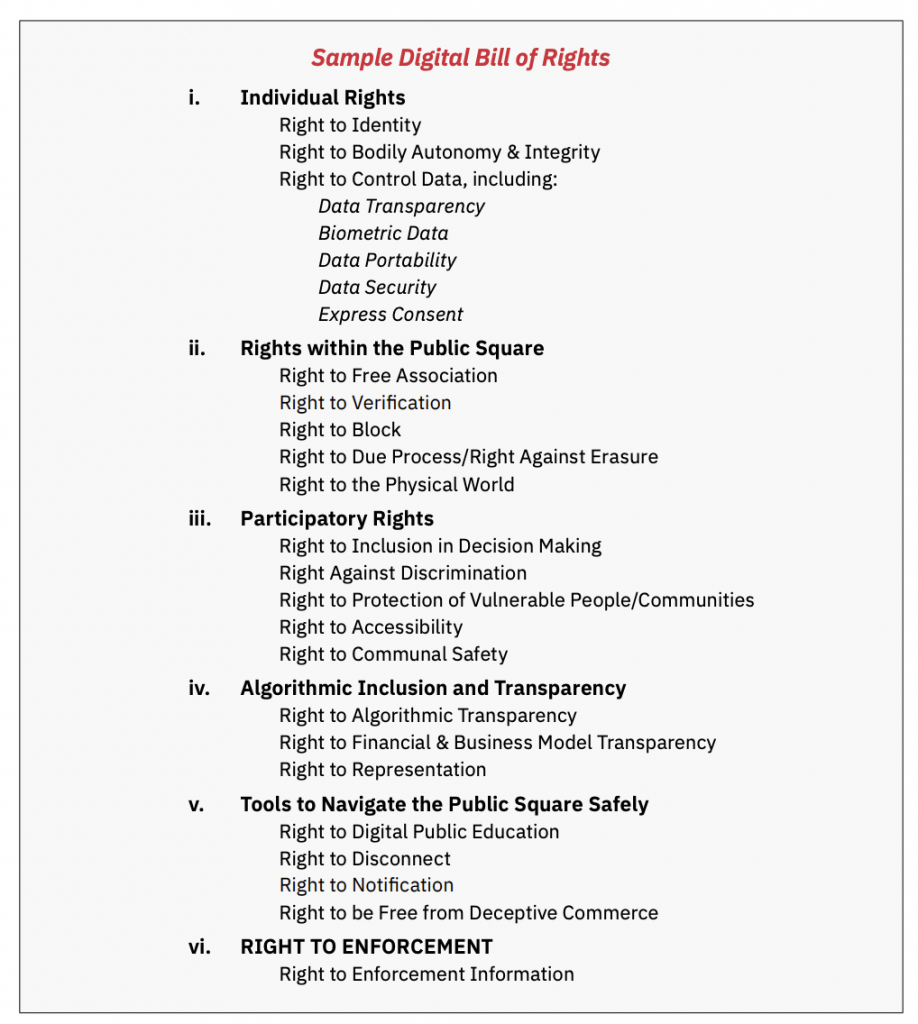

Les acteurs technologiques, la société civile, le milieu universitaire et le public devraient élaborer une déclaration des droits numériques des utilisateurs, un code de conduite des développeurs et des principes de gouvernance de l’information numérique afin de promouvoir leur adoption et leur adhésion, selon l’étude. “Social Media: The Canary in the Coal Mine – A Digital Bill of Rights, Developers’ Code of Conduct, and Information Governance Principles for a Healthier Digital World”…

Pour un cadre de gouvernance efficace des médias sociaux

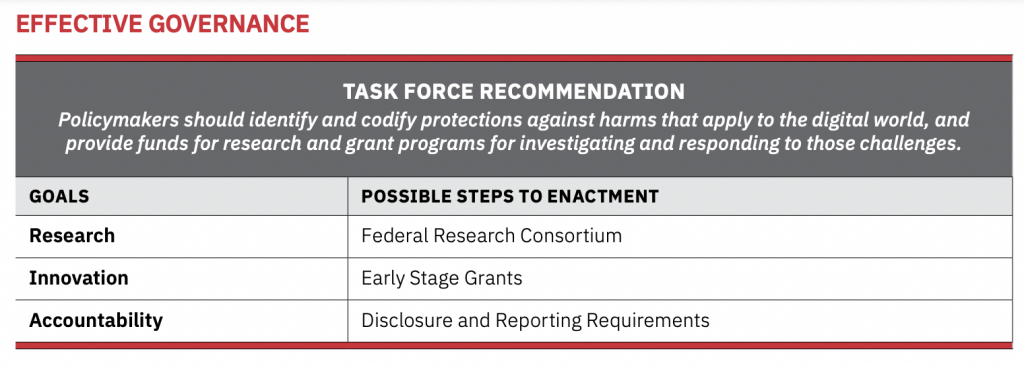

Le monde numérique rend nos autorités de gouvernance actuelles inadéquates, confrontées aux nouveaux défis technologiques. Les décideurs politiques et les régulateurs manquent actuellement de ressources pour protéger efficacement un avenir numérique positif. Les droits numériques nécessitent des protections que nos structures actuelles n’offrent pas entièrement.

La régulation des nouvelles technologies doit reposer sur des recherches fiables, un écosystème d’innovation privée renforçant l’intérêt public ainsi qu’une gouvernance qui responsabilise de manière équitable et cohérente.

1) Établir de futurs programmes de recherche et de subventions pour les universitaires

La base consiste d’abord à clarifier quand et comment les plateformes peuvent partager des données avec des chercheurs du milieu universitaire tout en protégeant les droits à la vie privée des utilisateurs.

La recherche devrait se concentrer sur :

- L’établissement de définitions et de bases de référence pour les dommages numériques et les préjudices (y compris psychologiques) ;

- Des mécanismes de signalement efficaces pour les problèmes de sécurité des utilisateurs ;

- Des ensembles de données ouvertes à la recherche ;

- Des expérimentations de technologie qui soutiennent les principes de démocratie et de transparence.

2) Distribuer des subventions pour encourager l’innovation

En outre, des programmes de financement spécifique devraient être exploré pour inciter les entreprises ou les investisseurs en phase de démarrage promouvant des principes de gouvernance démocratique auprès notamment des fonds de capital-risque émergents

3) Établir des exigences de reporting et de responsabilisation

Des rapports obligatoires par les plateformes pourraient s’inspirer structurellement des modèles mis en œuvre par les investisseurs autour des principes environnementaux, sociaux et de gouvernance pour tous les médias sociaux, entreprises de médias et plateformes.

Des exigences spécifiques pourraient être intégrées :

- Des normes sociales démocratiques ;

- L’audit algorithmique, la transparence des algorithmes et la prise de décision automatisée ;

- Le partage de données avec les chercheurs ;

- Les pratiques commerciales monétisant les données des utilisateurs ;

- Les moyens de mesurer la crédibilité/l’exactitude du contenu original

- L’évaluation des risques sanitaires et systémiques actuels ;

- Les normes de portabilité ou d’interopérabilité ;

- L’incidence des publications parrainées ou amplifiées par des gouvernements étrangers ;

- L’accessibilité et l’inclusion.

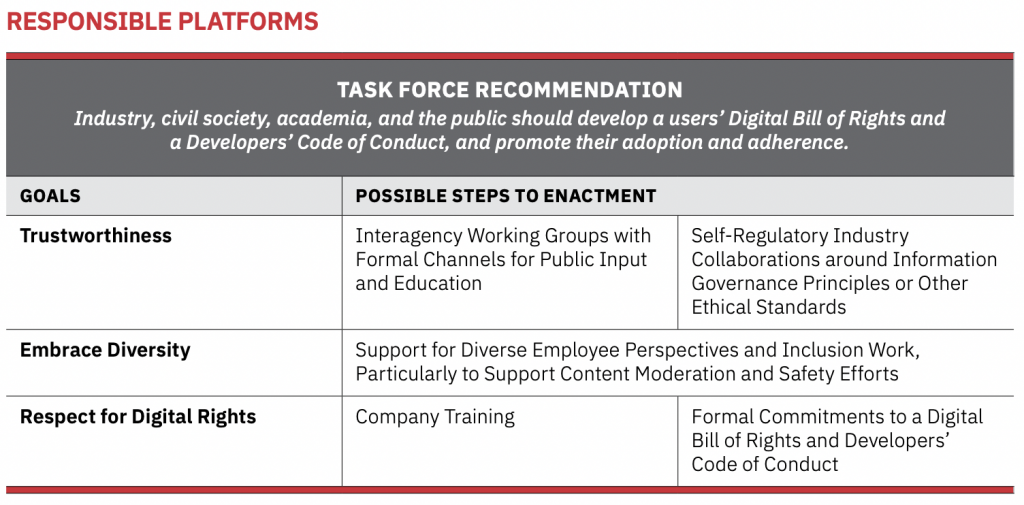

Pour des plateformes responsables des médias sociaux

Les technologies confèrent aux plateformes un rôle démesuré dans les interactions, sans être encore bien adaptées. La société attend plus des entreprises, ainsi que de leurs investisseurs, avec leur prise de pouvoir croissante. L’histoire a montré l’importance d’assurer un plus grand rôle aux consommateurs et à leur protection. Alors que des portions importantes de la place publique passent aux mains du privé, les plateformes doivent s’adapter à leurs nouvelles responsabilités publiques.

Les plateformes doivent gagner la confiance des consommateurs en appliquant judicieusement et équitablement leurs politiques, en alignant leurs incitations sur les intérêts des utilisateurs et en présentant des informations fiables, sans être les arbitres ultimes de la vérité ; au contraire, la transparence et la capacité des utilisateurs à déchiffrer la crédibilité sont deux facteurs clés pour gagner la confiance du public.

Les plateformes responsables établiront également des normes éthiques élevées en interne, à la fois pour leurs employés et pour leurs décisions commerciales plus larges. Alors que les plateformes bénéficient d’un pouvoir sociétal et d’un espace considérable pour innover sans réglementation, elles doivent également s’engager à respecter des normes éthiques pour limiter les abus de ce pouvoir et de cette discrétion. Une partie de cet engagement englobe la nécessité pour les plateformes d’éduquer le public sur le fonctionnement de leurs algorithmes afin que le public puisse vraiment surveiller ses intérêts dans le monde numérique. Enfin, les plateformes doivent respecter les droits numériques de tous leurs utilisateurs – un élément essentiel pour leur relation positive avec la société américaine.

La Charte des droits numériques et le Code de conduite des développeurs fournissent des modèles de normes et de standards qui pourraient être adoptés par les producteurs de la société numérique et utilisés pour éclairer leurs politiques afin de produire une stratégie mieux coordonnée pour l’ensemble de la société pour un univers numérique sain.

1) Une stratégie numérique pour toute la société adoptée pour renforcer la fiabilité des plateformes

Pour être crédible et donc efficace, une stratégie sociétale pour une société numérique saine devra être élaborée selon un processus qui évite de donner un avantage économique à une entreprise. Il doit créer un espace pour les nouveaux entrants et éviter un monopole du pouvoir pour une seule grande plateforme.

L’élaboration de ces normes et standards règlementés nécessitera l’ouverture de canaux formels pour la contribution du public, l’engagement dans le dialogue et la garantie que les points de vue des minorités seront entendus. Ces efforts pourraient compléter le code de bonnes pratiques de l’UE sur la désinformation, qui a réuni les plateformes en ligne et l’industrie de la publicité pour s’autoréguler. Un effort de toute la société nécessite un engagement d’une multitude de façons à différents niveaux de spécificité pour générer l’adhésion et opérationnaliser les nouvelles normes et standards sur le terrain.

L’industrie technologique devrait être encouragée à établir ses propres normes qui promeuvent l’essence des principes éthiques de gouvernance de l’information, car l’autorégulation est dans le meilleur intérêt des publics et sur une base commune à l’industrie pour codifier un comportement approprié.

2) Adopter la diversité

L’éthique va au-delà de l’appel ordinaire pour assurer l’inclusivité, l’accessibilité, la diversité de pensée et l’équité. Les plateformes en ligne doivent adopter la diversité en intégrant les points de vue de diverses communautés dans le processus de conception dès le premier jour, les services et les produits prendront plus efficacement en compte les différentes perspectives sur la manière dont ils sont utilisés afin d’en limiter les dommages.

3) Garantir le respect des droits numériques

Pour intégrer ces concepts sur le terrain et partager les meilleures pratiques, la formation des employés sur les plateformes est indispensable en matière de conception, d’exploitation, d’administration et de gouvernance éthiques. Cette formation doit inclure un engagement signé des employés à suivre un code de conduite des développeurs et des entreprises à adhérer aux principes de gouvernance de l’information, en plus de respecter les droits numériques des utilisateurs.

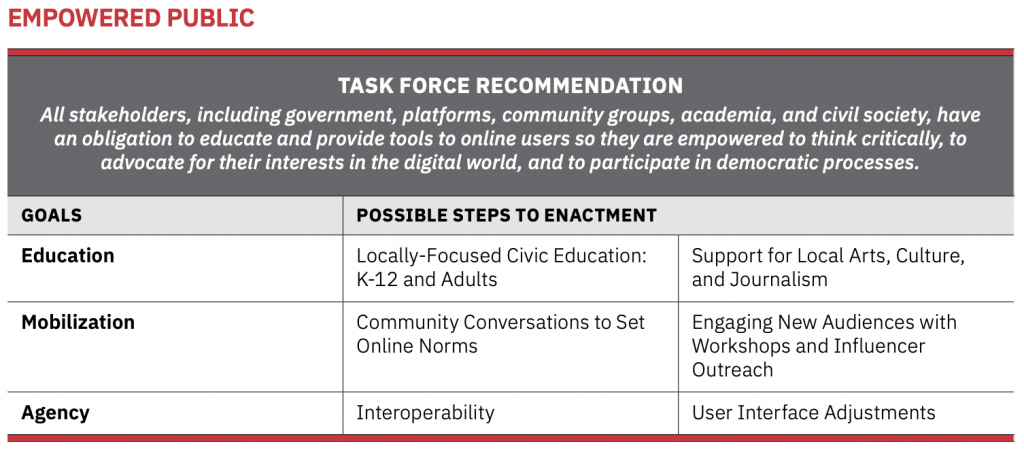

Pour un public autonomisé et formé aux médias sociaux

Une nouvelle ère numérique offre d’immenses possibilités aux individus, mais seulement si nous sommes correctement préparés à gérer cette complexité. Dans le modèle actuel, l’attention des individus est traitée comme un produit à vendre, avec l’éducation des plateformes sur le fonctionnement de leurs algorithmes, le public doit se préparer à évaluer les implications des nouvelles dynamiques de pouvoir dans le paysage numérique, afin de ne pas être laissé vulnérable à une exploitation future par des intérêts étroits.

Les individus doivent activement s’attaquer à la complexité et aux implications de leur existence en ligne. Cela n’est possible qu’avec une certaine éducation sur les technologies elles-mêmes, la manière dont elles influencent le choix individuel et les motivations des plateformes et des producteurs de contenu. Pour sauvegarder les droits et les intérêts des consommateurs, les individus doivent se mobiliser et plaider auprès des décideurs.

Bien qu’il existe des biens sociaux qui sortent de ces modèles, comme des produits gratuits, les utilisateurs ont besoin de la liberté de choisir leurs relations, plutôt que d’être forcés à accepter des réalités monopolistiques afin qu’ils soient habilités à penser de manière critique, à défendre leurs intérêts dans le monde numérique et à participer aux processus démocratiques.

La démocratie exige qu’un public engagé réfléchisse de manière critique aux règles et aux normes nécessaires à une société saine, et cela vaut autant pour la société numérique que pour le monde réel. Toutes les parties prenantes doivent avoir la possibilité de participer à la spécification de ces règles et normes, y compris le développement et l’utilisation d’outils pour les réaliser.

1) Développer des outils civiques d’éducation pour assurer une meilleure compréhension sociétale des risques et opportunités présentés par la participation en ligne

Les parties prenantes doivent développer, promouvoir et diffuser des outils qui soutiennent l’éducation civique qui favorise une société numérique saine. La finalité vise à offrir une compréhension politiquement neutre et à promouvoir la pensée critique tout en fournissant une compréhension de base de la technologie :

- La littératie numérique ;

- La conscience de la confidentialité et de la sécurité ;

- L’éthique technologique ;

- La préparation numérique ;

- L’atténuation des risques numériques ;

- La gestion de la santé mentale.

La pensée critique, à savoir la remise en question constante du contenu, des algorithmes et des autres structures systémiques de la société numérique, est donc un élément important de l’autonomisation du public aux côtés de la compréhension générale de la technologie et de ses conséquences. Cette réflexion critique sur le monde numérique devrait faire partie d’une éducation civique généralisée.

D’autres formes de discussion publique pourraient porter sur la manière d’identifier la més/désinformation en ligne, les dommages causés par les environnements de médias sociaux toxiques et incivils et les mesures de sécurité pour protéger les enfants.

2) Mobiliser des outils démocratiques pour protéger les utilisateurs et la société des dommages potentiels

Un public responsabilisé a besoin d’une voix démocratique dans la société numérique, ce qui peut être accompli par des moyens remarquablement similaires à ceux du monde physique. Les campagnes peuvent tirer parti du pouvoir de mobilisation pour faire pression sur les plateformes et le gouvernement sur des questions telles que l’augmentation des capacités de propriété des utilisateurs sur les plateformes, l’adoption d’une déclaration des droits numériques, l’amélioration de la transparence des données, l’accessibilité et l’inclusion, et d’autres questions clés.

3) Donner aux utilisateurs une agence sur leurs expériences en ligne

Le dernier élément de l’autonomisation des utilisateurs est qu’ils doivent avoir l’opportunité et la capacité de participer à la définition des contours de leurs expériences personnelles en ligne. Idéalement, ils doivent contrôler leurs propres données, faire des choix sans être gênés par la manipulation ou le subterfuge de la plate-forme, avoir la liberté de se déplacer de manière transparente entre les plateformes et accéder à des outils qui leur donnent plus de contrôle sur différents aspects de leurs expressions en ligne.

La capacité de « voter avec ses pieds » en quittant des plateformes qui ne répondent pas aux besoins ou aux attentes des utilisateurs est un élément essentiel, même si la portabilité des informations non transférables empêche les utilisateurs d’exercer cette faculté.

Une première étape intéressante dans cette direction serait une adoption des normes d’interopérabilité, dans laquelle plateformes s’engageraient sur les priorités des utilisateurs lors de l’élaboration de normes d’interopérabilité et de meilleures pratiques pour offrir aux utilisateurs plus de contrôle sur leurs profils, leurs données, la création de contenu et leurs informations personnelles.

Bien que les solutions réelles puissent varier selon la plateforme, la création de mécanismes permettant aux utilisateurs de participer à l’élaboration de leurs propres expériences dans la société numérique est fondamentale pour l’essor des principes démocratiques en ligne.